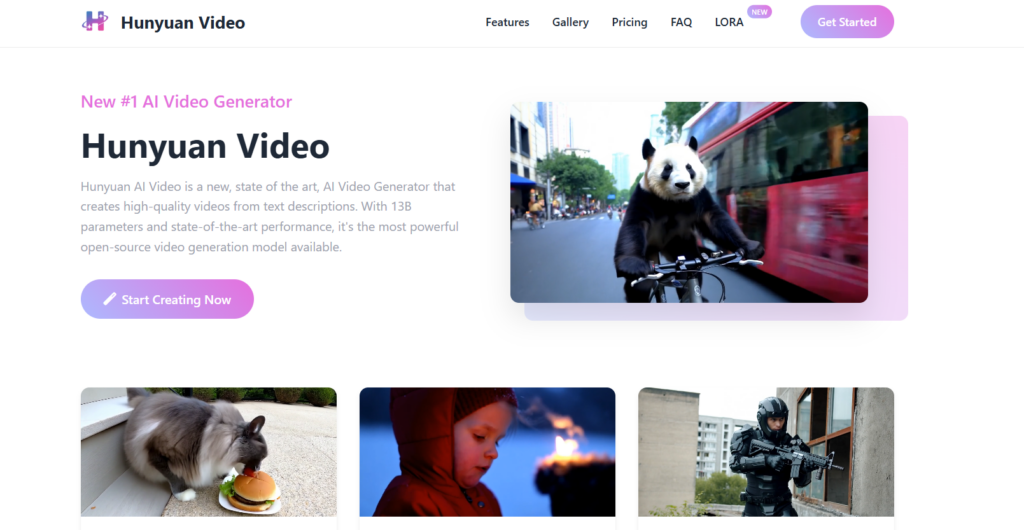

Hunyuan AI video generator za darmo to zaawansowany, otwartoźródłowy model generowania wideo oparty na sztucznej inteligencji, opracowany przez chińskiego giganta technologicznego Tencent. Został publicznie zaprezentowany 3 grudnia 2024 roku i jest uznawany za jedno z najbardziej zaawansowanych narzędzi tego typu dostępnych w domenie open-source. Model ten wyróżnia się zdolnością do tworzenia wysokiej jakości wideo na podstawie opisów tekstowych, oferując realistyczne ruchy, spójność wizualną i różnorodność stylistyczną.

Kluczowe cechy Hunyuan Video:

- Parametry i architektura:

- Posiada 13 miliardów parametrów, co czyni go największym otwartoźródłowym modelem wideo na świecie (stan na marzec 2025).

- Wykorzystuje architekturę Transformer z mechanizmem Full Attention oraz hybrydowy design „Dual-stream to Single-stream”, co pozwala na efektywne łączenie tekstu i wizualizacji.

- Zastosowano Causal 3D VAE do kompresji przestrzenno-czasowej, co zapewnia płynność i jakość generowanych klipów.

- Możliwości generowania:

- Tworzy wideo o długości 5 sekund (129 klatek) w rozdzielczościach do 720p (720×1280 px), z opcjami niższej jakości (np. 540p) dla szybszego przetwarzania.

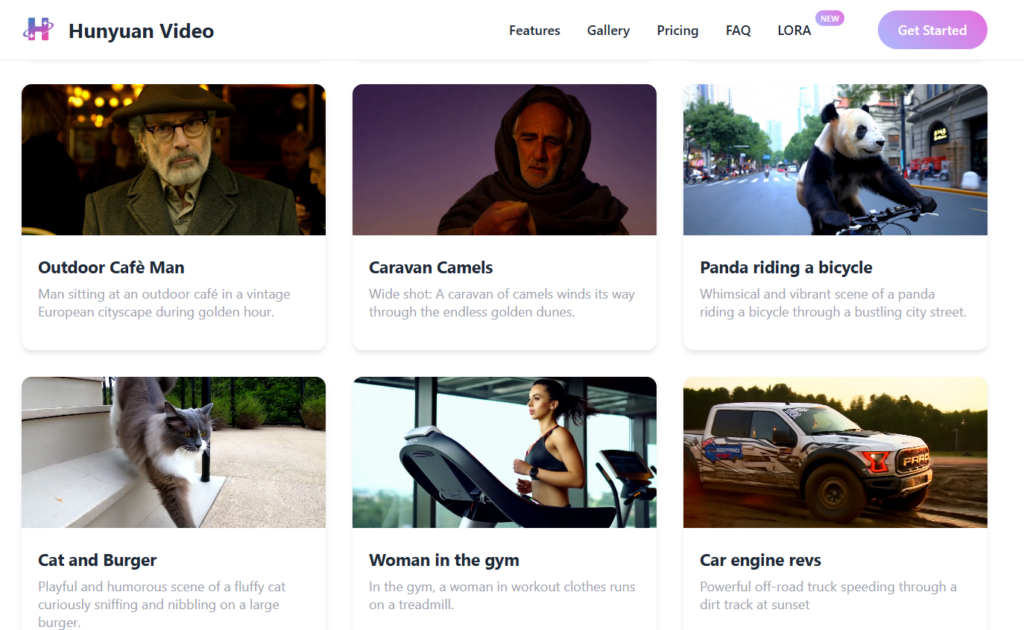

- Obsługuje różnorodne proporcje obrazu (np. 9:16, 16:9, 4:3) i style – od realistycznych po animowane.

- W marcu 2025 roku wprowadzono HunyuanVideo-I2V, umożliwiając generowanie wideo z obrazów, oraz wsparcie dla rozdzielczości 2K z dźwiękiem i synchronizacją ust.

- Wydajność:

- Według ocen ludzkich, Hunyuan Video przewyższa wcześniejsze modele open-source (np. Luma 1.6) oraz niektóre komercyjne, jak Runway Gen-3, w kategoriach jakości wizualnej (95,7%), dynamiki ruchu (66,5%) i zgodności tekst-wideo (61,8%).

- Oferuje zaawansowane efekty kinematograficzne, takie jak naturalne przejścia scen i ruchy kamery.

- Wymagania techniczne:

- Minimalnie wymaga karty NVIDIA z 45 GB VRAM dla 544×960 px lub 60 GB dla 720p. Wersje zoptymalizowane (np. HunyuanVideoGP) działają na 12-24 GB VRAM.

- Testowane na GPU H800/H20 w systemie Linux; społeczność open-source dostosowała model do słabszych konfiguracji.

Dostępność:

- Kod źródłowy, wagi modelu i przykłady są dostępne na GitHubie (Tencent/HunyuanVideo).

- Można go uruchomić lokalnie po instalacji (np. ComfyUI) lub przetestować na platformach takich jak fal.ai czy goenhance.ai.

- Społeczność aktywnie rozwija dodatki, jak HunyuanVideo-I2V (obraz do wideo) czy wersje GGUF dla niższego zużycia pamięci.

Zastosowania:

Hunyuan Video sprawdza się w tworzeniu profesjonalnych treści wideo, od reklam i klipów społecznościowych po artystyczne animacje. Przykładowe prompty, jak „niski kąt śledzący motocykl BMW na ruchliwej ulicy Nowego Jorku” czy „astronauta na Marsie z kreaturą w tle”, pokazują jego zdolność do generowania szczegółowych, dynamicznych scen.

Przyszłość:

Tencent zapowiada dalszy rozwój, w tym dłuższą długość klipów, lepsze zrozumienie kontekstu i integrację z narzędziami edycji. Dzięki otwartoźródłowemu charakterowi Hunyuan Video zyskuje przewagę nad zamkniętymi modelami, umożliwiając społeczności dostosowywanie i optymalizację, co czyni go przełomowym narzędziem w generatywnej AI.

Oficjalna strona https://hunyuanvideoai.com/