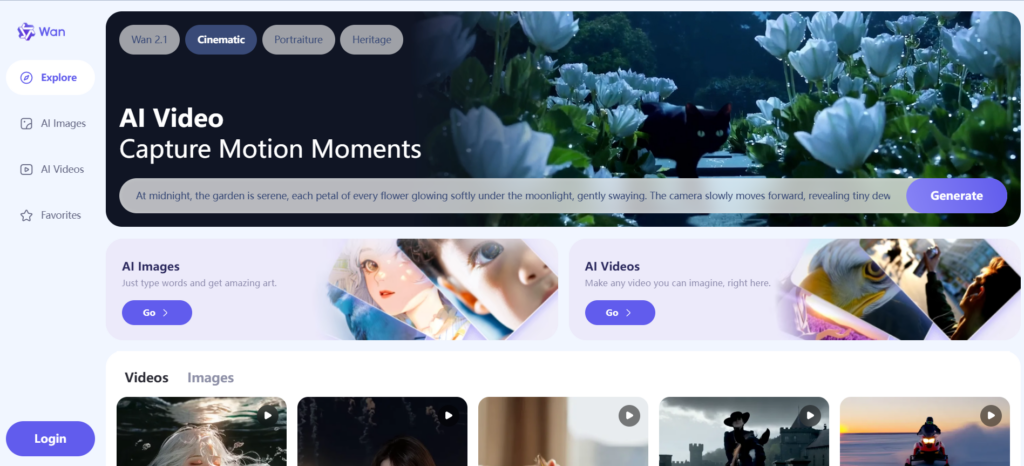

Wan AI najlepszy generator wideo za darmo do pobrania na komputer. Twórz wysokiej jakości filmy z zaawansowaną obsługą ruchu i obsługą wielu języków. Oprogramowanie open source, łatwe w użyciu.

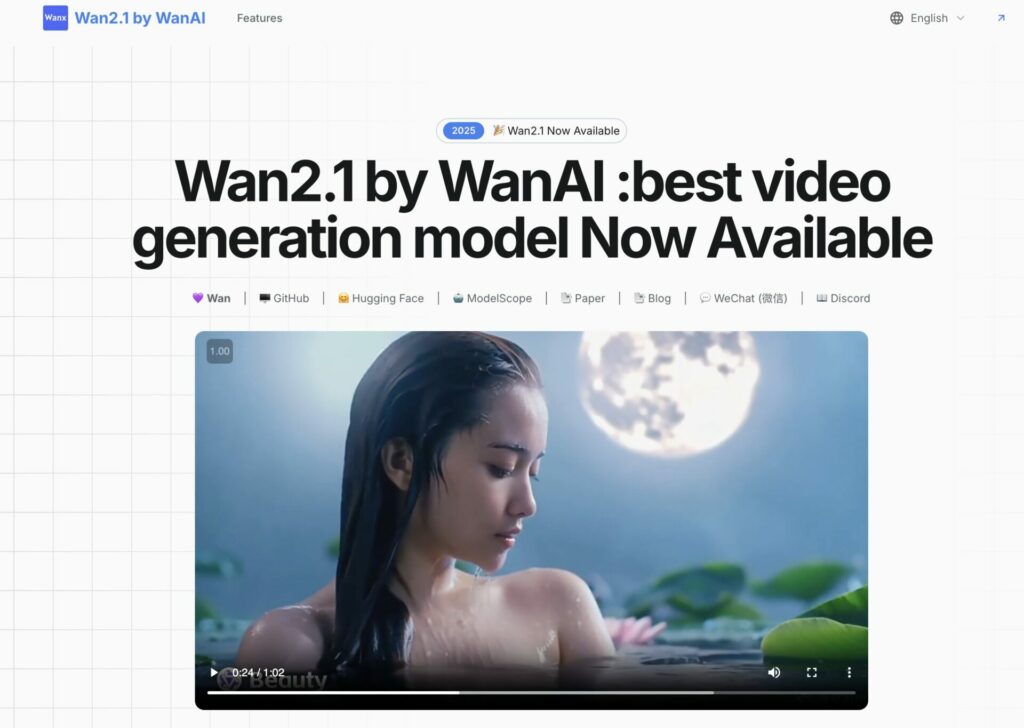

Wan 2.1 to zaawansowany, otwartoźródłowy model generatywnej sztucznej inteligencji stworzony przez Tongyi Lab w ramach Alibaba Group. Specjalizuje się w przekształcaniu tekstu i obrazów w wysokiej jakości wideo, a także oferuje funkcje edycji wideo i generowania obrazów. Jest częścią rodziny modeli Wan, które ewoluowały od prostszych wersji do obecnej, potężnej iteracji. Teraz możesz tworzyć niesamowite animacje i generować wideo za pomocą AI.

Wan 2.1

- Text-to-Video (T2V):

- Wpisujesz opis, np. „złoty retriever biegnący po plaży w słońcu”, a model generuje realistyczne wideo.

- Obsługuje zarówno angielski, jak i chiński tekst, co czyni go unikalnym wśród modeli wideo.

- Image-to-Video (I2V):

- Przekształca statyczne obrazy w dynamiczne klipy, np. animuje zdjęcie w ruchomy film.

- Edycja wideo:

- Umożliwia modyfikację istniejących filmów, np. zmiana stylu czy dodanie efektów.

- Text-to-Image (T2I):

- Generuje obrazy statyczne na podstawie promptów, jako dodatek do funkcji wideo.

- Technologia:

- Bazuje na Variational Autoencoders (VAE) i Diffusion Transformers (DiT), co zapewnia płynne przejścia, realistyczne ruchy i wysoką jakość wizualną.

- Model 14B (14 miliardów parametrów) jest flagowy, ale istnieje też lżejsza wersja 1.3B, wymagająca tylko 8,19 GB VRAM, co pozwala uruchomić go na większości konsumenckich kart graficznych.

- Dostępność:

- Open-source: Kod i wagi modelu są dostępne na Hugging Face (np. Wan-AI/Wan-2.1-T2V-14B).

- Darmowy dostęp online: Można testować na platformach takich jak Alibaba Cloud Model Studio lub Monica AI.

- Planowane pełne otwarcie: W Q2 2025 roku mają zostać udostępnione dane treningowe i zestaw narzędzi dla deweloperów.

- Stylizacja:

- Oferuje ponad 100 stylów artystycznych, od cyberpunku po malarstwo olejne, co daje dużą elastyczność.

Zastosowania:

- Twórcy treści: Szybkie tworzenie wideo na media społecznościowe czy reklamy.

- Gry: Generowanie cutscen czy animacji.

- Edukacja: Ilustracje wizualne do lekcji.

- Badania: Eksperymenty z technologią generatywną.

Porównanie z innymi:

- Sora (OpenAI) : Wan 2.1 jest chwalony za szybkość (1080p w 15 sekund na minutę treści) i elastyczność, choć Sora może przewyższać go w fotorealizmie i długości klipów (do 20 sekund w wersji Pro).

- Stable Diffusion : Wan 2.1 jest bardziej skoncentrowany na wideo, podczas gdy Stable Diffusion to głównie obrazy, choć oba są otwarte.

- Luma AI : Wan 2.1 oferuje szersze wsparcie językowe i więcej stylów niż Luma, ale Luma może być lepsza w modelach 3D.

Przykład:

- Prompt: „taniec baletowy w lesie, styl akwarelowy”.

- Efekt: Wan 2.1 generuje krótki klip z płynnymi ruchami tancerzy wśród drzew, w delikatnej, malarskiej estetyce.

Jak zacząć?

- Online: Wejdź na monica.im lub wan-ai.org, zaloguj się i wpisz prompt.

- Lokalnie: Pobierz model z Hugging Face, zainstaluj za pomocą Pinokio AI lub ręcznie (wymaga GPU, np. RTX 3060+), i uruchom skrypt Pythona.

Dlaczego warto?

Wan 2.1 wyróżnia się darmowym dostępem, otwartością i niskimi wymaganiami sprzętowymi w porównaniu do płatnych konkurentów. Społeczność na X i forach chwali jego wydajność, wskazując, że przewyższa niektóre komercyjne modele pod względem stosunku jakości do ceny. Darmowe i otwarto-źródłowe narzędzie AI pomoże Ci tworzyć filmy na podstawie tekstu, animować obrazy, a nawet generować realistyczne przejścia między klatkami! To idealne rozwiązanie dla twórców treści, grafików i wszystkich, którzy chcą eksperymentować z nowoczesną technologią.